System przetwarzania rozproszonego

Armadillo

Armadillo

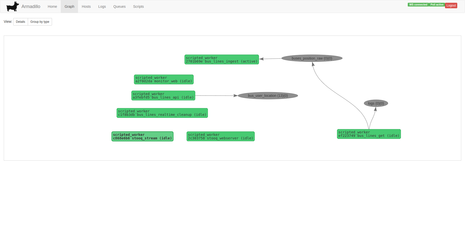

System powstał jako fundament do projektu mającego za zadanie scraping dużej ilości danych. Ostatecznie stał się frameworkiem do budowania systemów rozproszonego przetwarzania. Działanie systemu opiera się na przekazywaniu wiadomości w oparciu o kolejkę między workerami z których każdy wykonuje zadania napisane w języku JavaScript lub Golang. W ramach systemu można budować wiele podsystemów i uruchamiać workery z poziomu GUI. Dla przykładu zbudowanie crawlera działającego na kilkunastu maszynach VPS mającego wyjąć treść z listy setek tysięcy stron zajmuje około godziny.

- System działający na wielu fizycznych maszynach

- Aplikacja posiada wbudowaną maszynę wirtualną JavaScript, pisanie tasków workera odbywa się w tym języku

- Technologie Golang, RabbitMQ, JavaScript, Vue.js